Индексация сайта (индексирование, indexing) – это процесс добавления информации о ресурсе либо конкретных страницах в базу ПС. Это влияет на отображение площадки в результатах выдачи после ввода пользователем конкретного запроса. Контент, не проиндексированный Яндексом, Google либо другими системами, найти посредством поиска невозможно.

Основные этапы индексации

Индексация сайта выполняется специально разработанными роботами поисковых систем, которые функционируют по определенным алгоритмам. Общий принцип, следующий:

- ПС узнает о сайте.

- Основной робот осуществляет переход на ресурс и скачивает страницы для последующего анализа контента, помещая сведения во временную базу.

- Робот-краулер (от crawl, что означает «ползать») сканирует данные из промежуточной базы, анализируя полученный контент.

К информации, изучаемой краулером на сайте, относятся:

- тексты (им уделяется первоочередное внимание, после анализа данных информация подается в очередь на добавление в базу ПС);

- скрипты (игнорируются при изначальном посещении сайта, но после индексации основной информации и повторном сканировании краулер попытается определить и извлечь их содержимое);

- ссылки (если последние неизвестны поиску, информация отправляется основному роботу и процесс повторяется заново).

Боты посещают сайты с определенной периодичностью, проверяя добавленный контент и помещая в индекс. Причем верхние позиции при ранжировании занимают страницы, которые наиболее релевантны поисковому запросу пользователей, удовлетворяя их потребности.

Способы проверки индексирования сайта

Индексация страниц сайта проверяется несколькими методами, в т. ч. посредством инструментов панелей вебмастера Yandex и Google, специально предусмотренными операторами в поиске, букмарклетами, сторонними сервисами и расширениями.

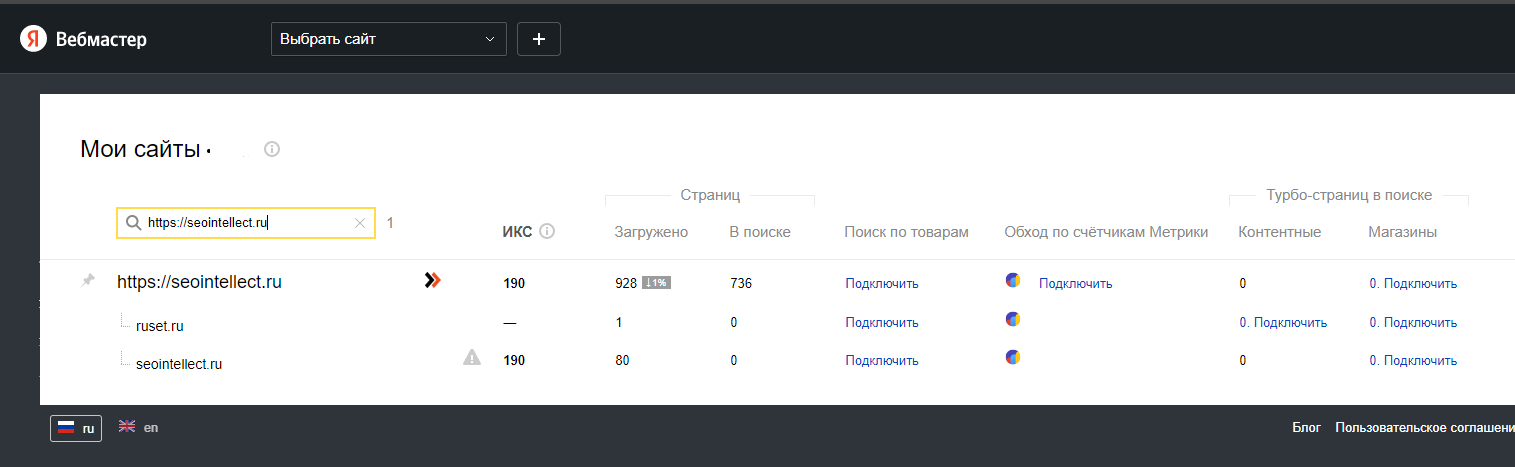

Яндекс.Вебмастер

После добавления сайта в Яндекс.Вебмастер на главной отображается адрес ресурса, а напротив – количество прошедших индексирование страниц.

Для детального ознакомления с информацией нужно:

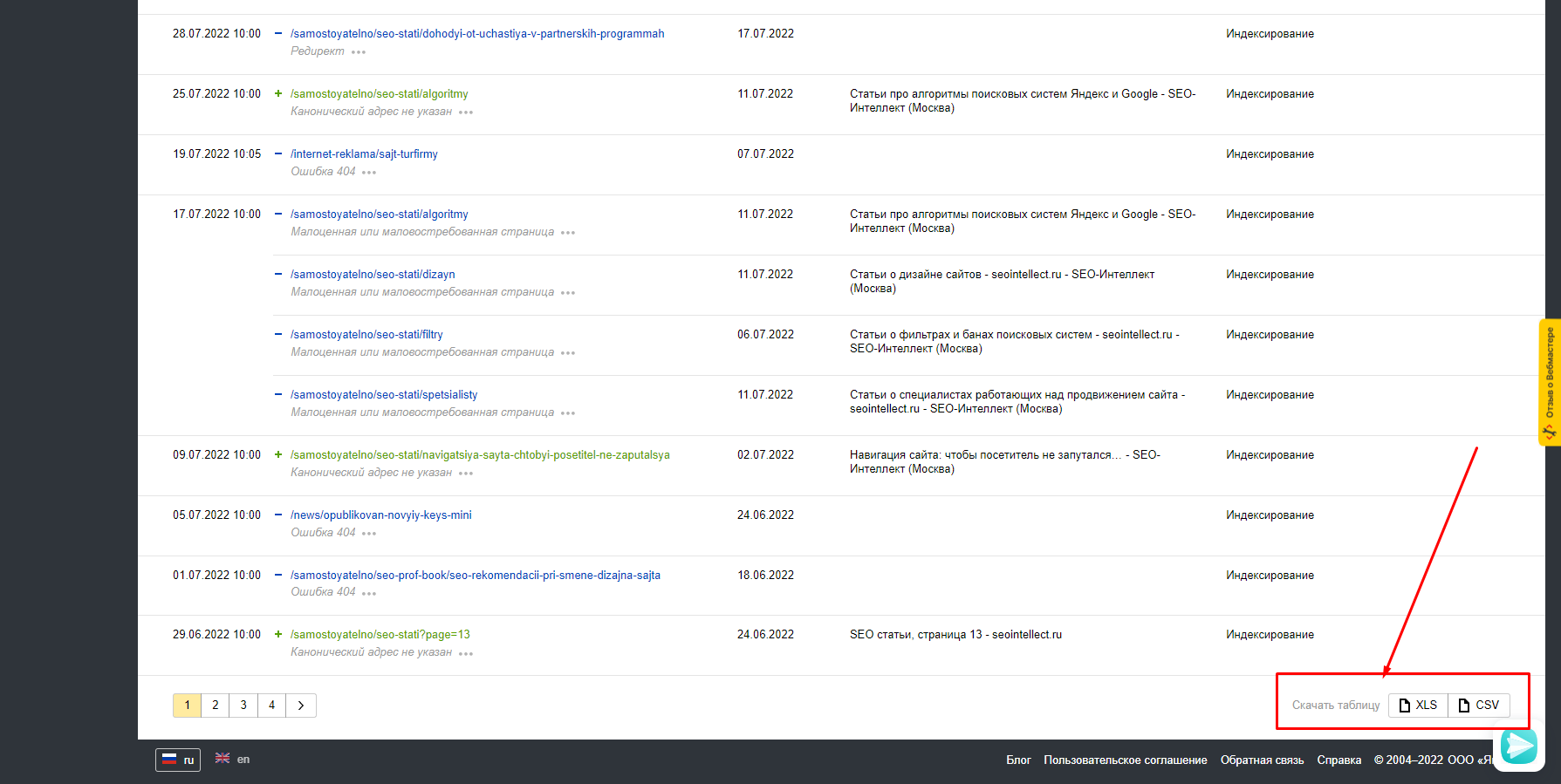

- Осуществить переход в подраздел «Индексирование», далее зайти во вкладку «Страницы в поиске» и нажать на кнопку «Все страницы».

- Кликнуть на «Скачать таблицу» (кнопка расположена внизу справа).

В итоге пользователь получит файл с отображением страниц сайта, которые проиндексированы поисковой системой Яндекса.

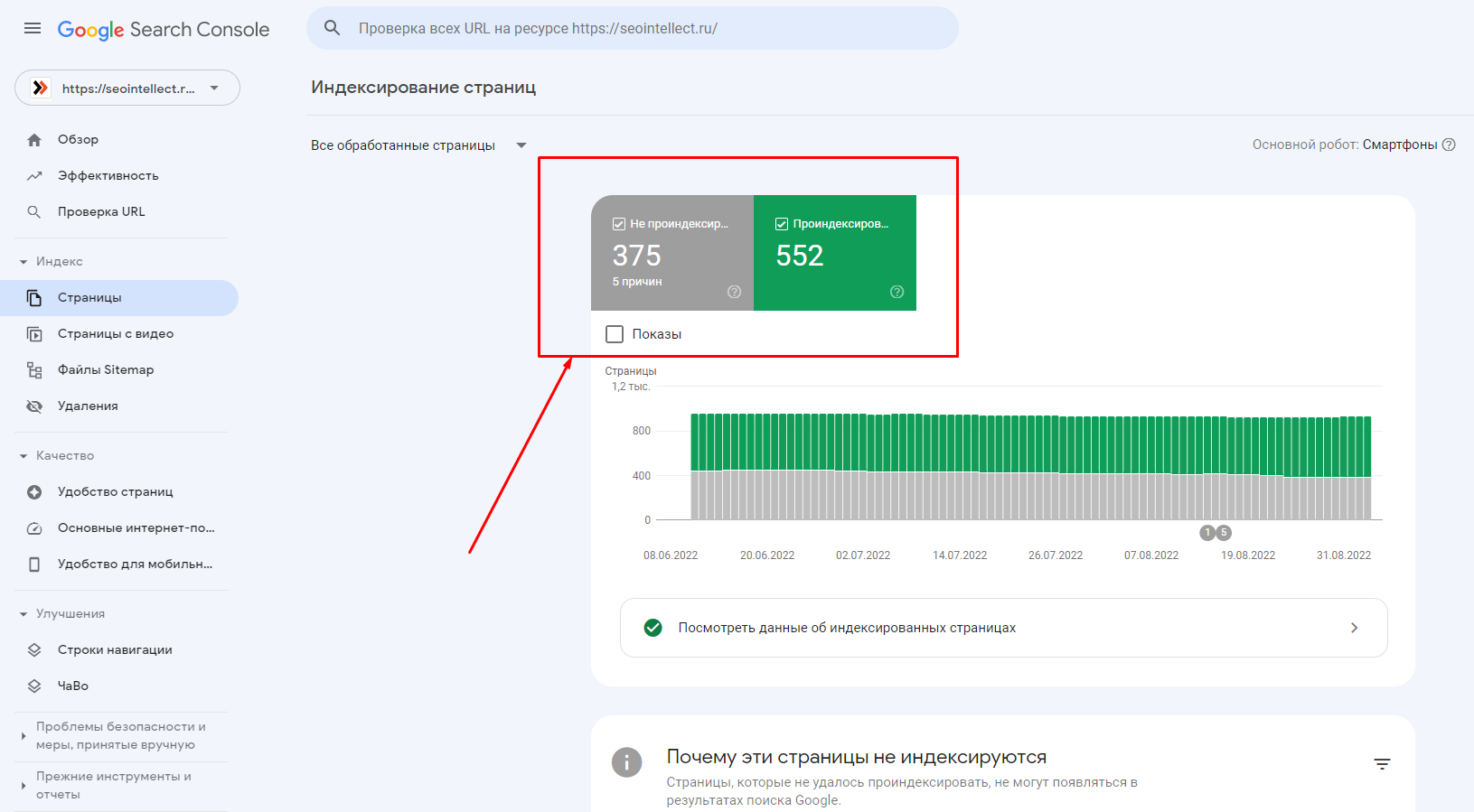

Google Search Console

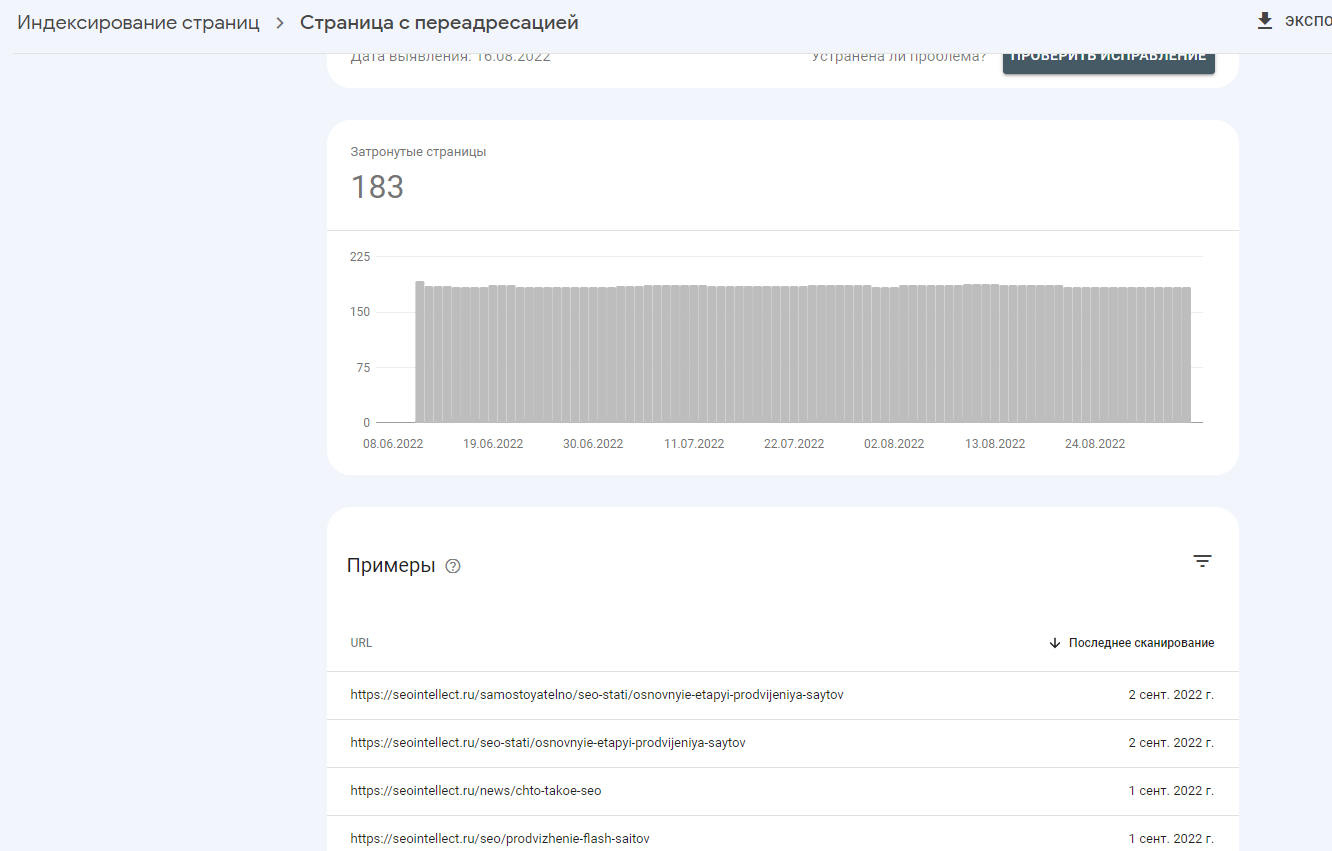

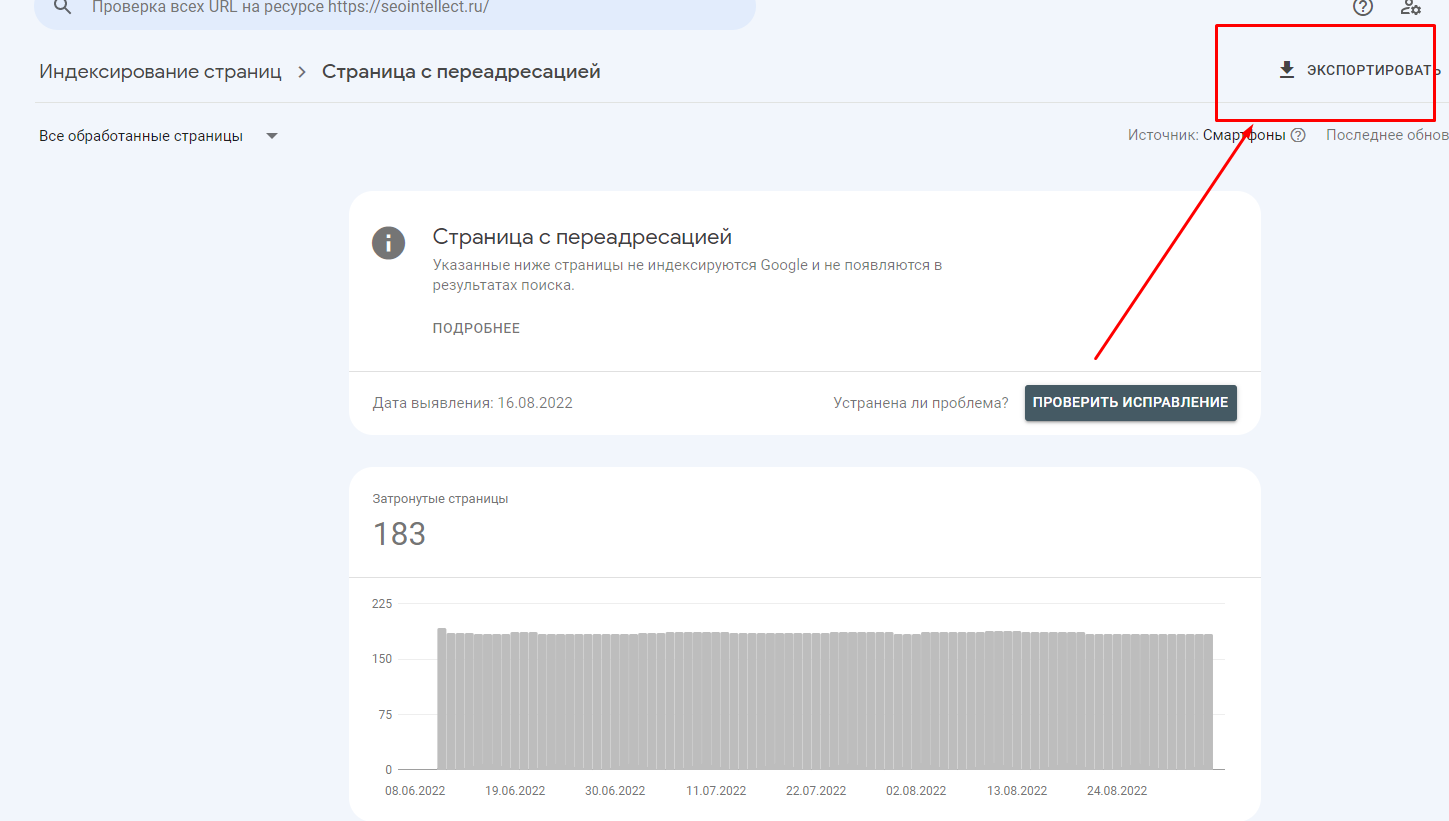

Для проверки индексации сайт обязательно добавляется в вебмастер Google. Во вкладке «Страницы» указывается число страниц, которые непосредственно принимают участие в поиске.

Для уточнения деталей о них необходимо:

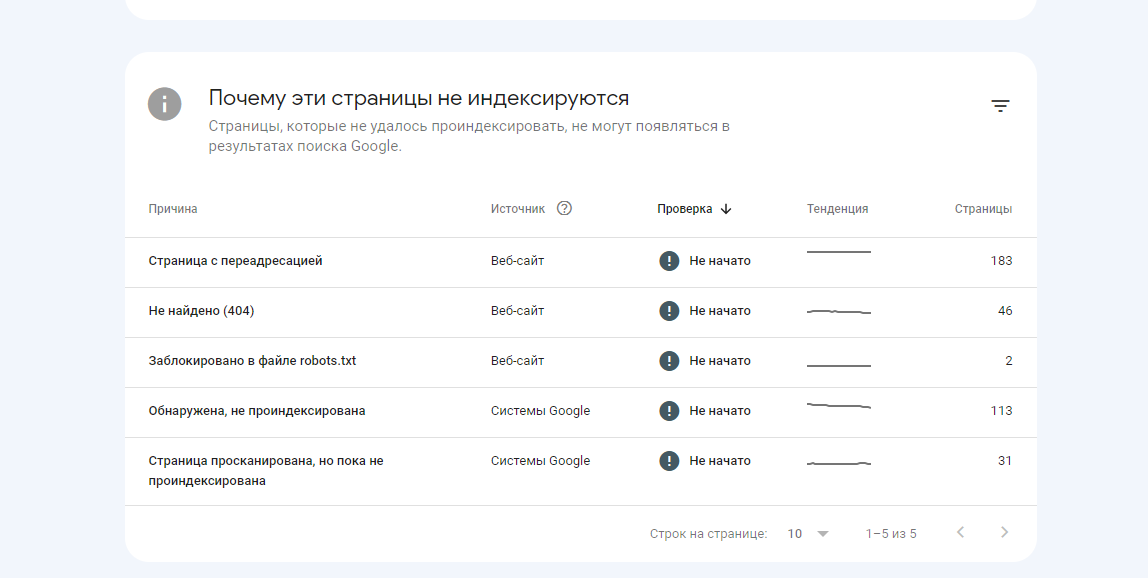

- Пролистать вниз страницу, после чего пользователю станут доступны необходимые данные. Такая информация представлена несколькими разделами, включающими страницы с ошибками, предупреждениями (либо без), исключенные из поиска.

- Нажать на нужную группу страниц в блоке, чтобы просмотреть подробный отчет.

Перечень страниц доступен во вкладке «Примеры» либо, для удобства анализа, есть возможность скачать список на компьютер.

Проверить индексирование операторами

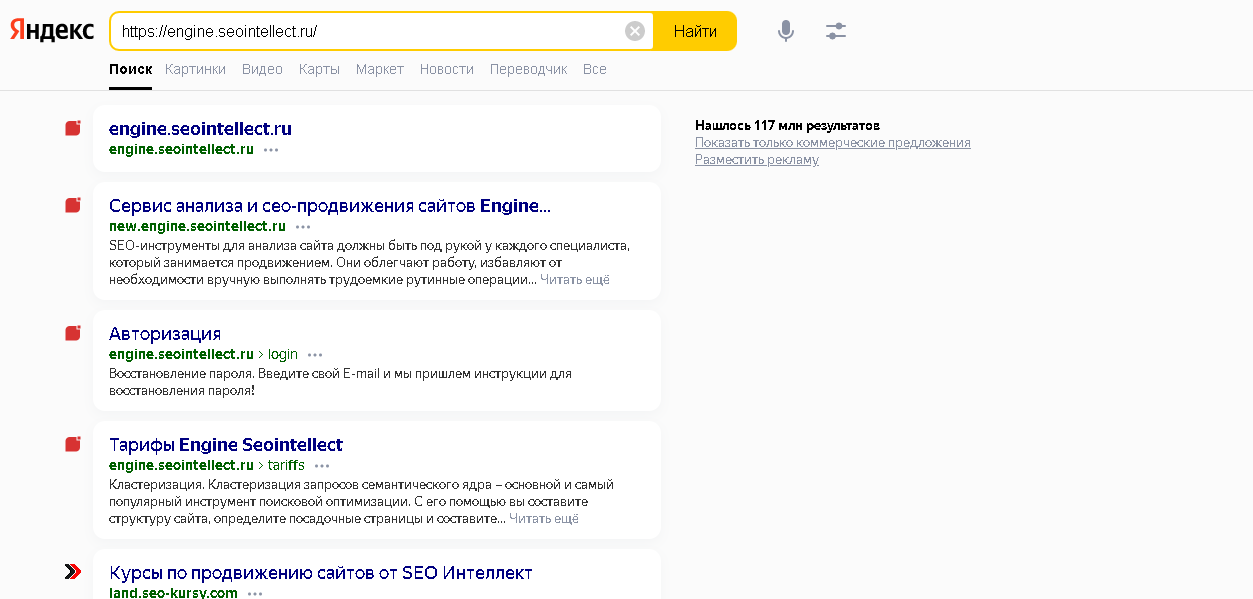

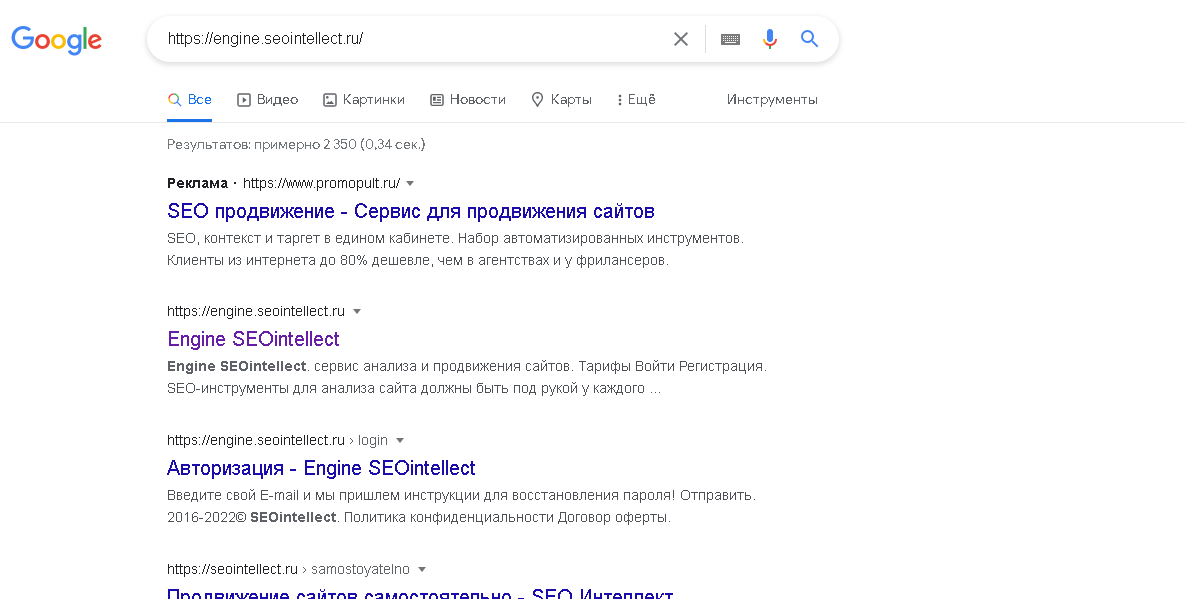

Чтобы проверить индексацию определенной страницы, достаточно скопировать и вставить соответствующий адрес в окно Яндекса либо Гугла. В результатах выдачи, при отсутствии санкций со стороны поисковой системы, должна отобразиться ссылка на сайт.

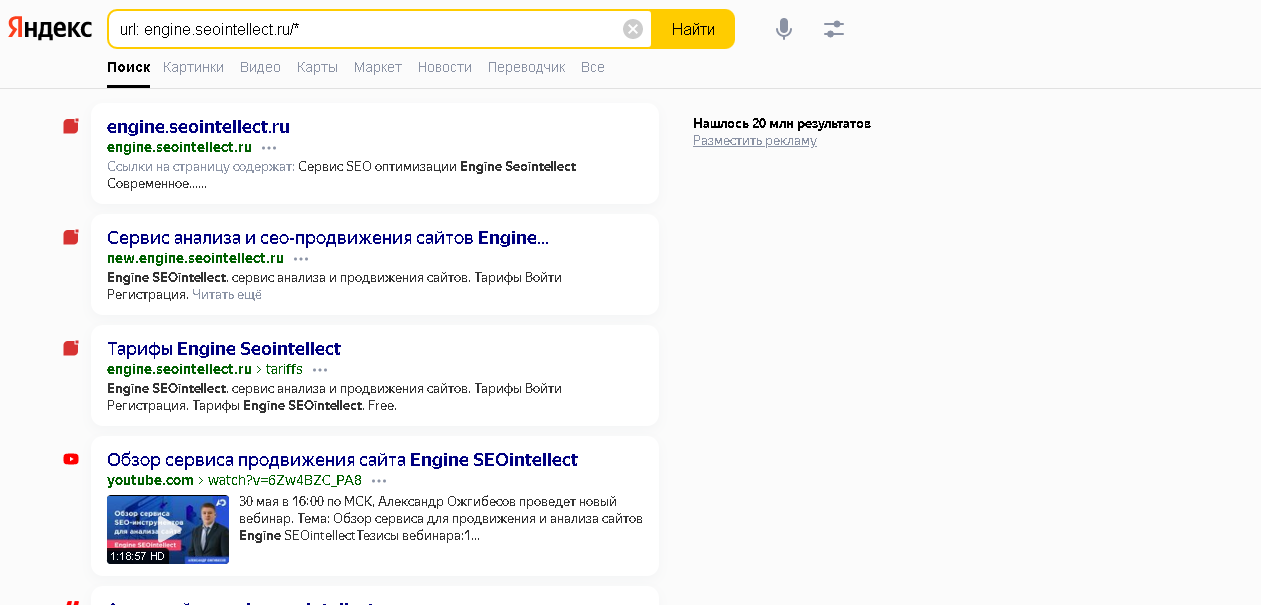

Для надежности рекомендуется воспользоваться специальными операторами. Например, для Google – это inurl (запрос – inurl: engine.seointellect.ru), Яндекса – url (url: engine.seointellect.ru). Если гиперссылка на сайт показывается в поиске, индексация пройдена, при пустой выдаче – нет.

Узнать общее количество попавших в базу Яндекса адресов страниц можно, введя аналогичный оператор, но только с названием домена, а в конце проставить звездочку, т. е.: url: engine.seointellect.ru/*.

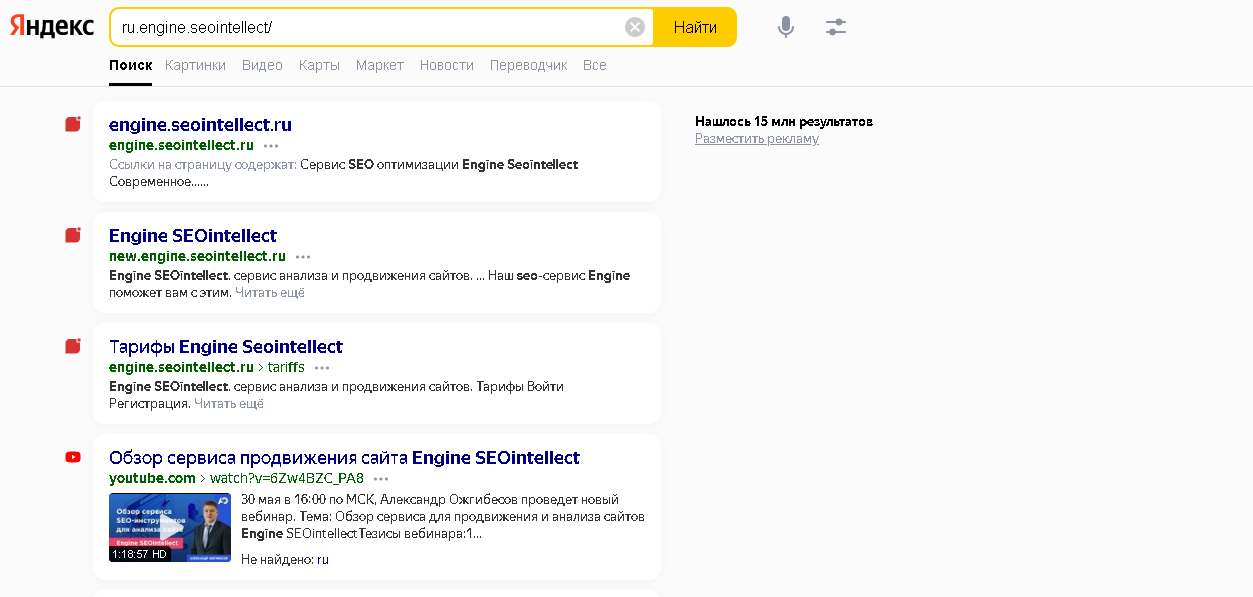

Однако часто характерна ситуация, когда сайт в поиске будет доступным с www и без. В итоге, для учета страниц на каждом ресурсе, дополнительно рекомендуется задействовать «логическое ИЛИ», представленное прямой чертой «|»: url:www. engine.seointellect.ru/* | url:engine.seointellect.ru/*. Аналогично работает оператор rhost:, только необходимо поменять местами доменную зону и название самого домена: rhost: ru.engine.seointellect/.

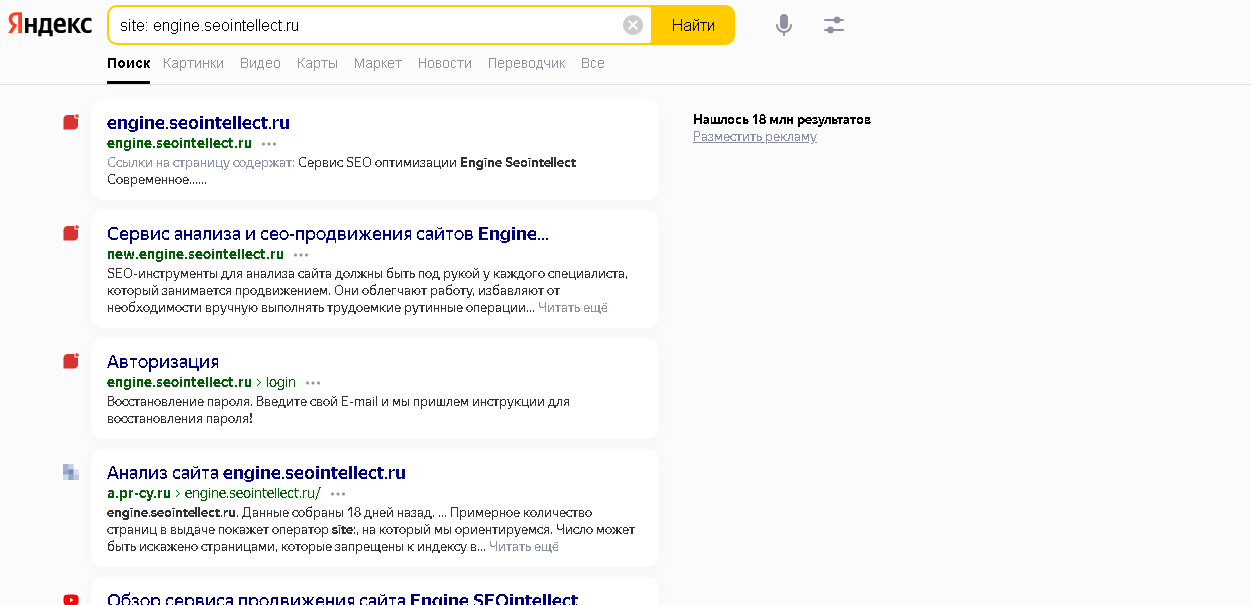

Другой вариант проверить индексацию – прописать site. Однако, в отличие от предыдущего способа, поисковик учтет поддомены (при их наличии).

Оператор site позволяет уточнить количество прошедших индексацию страниц на сайте не только в Яндексе, но и Google. Причем убрать отображение поддоменов допускается посредством прописывания inurl:.

Специальные плагины и сервисы

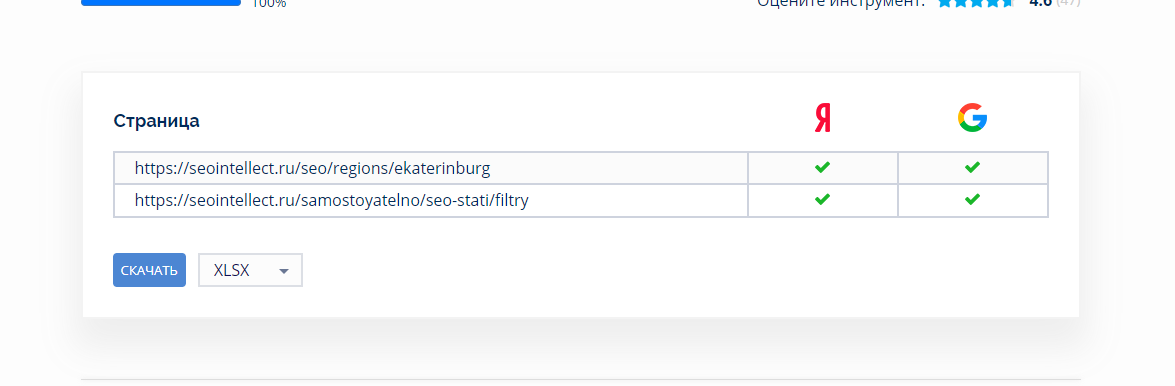

Индексация сайта либо отдельных страниц проверяется на различных сервисах, в т. ч.:

- arsenkin.ru/tools/indexation (для взаимодействия с онлайн-сервисом потребуется предварительная регистрация пользователя, после чего предоставляется возможность бесплатной ежедневной проверки индексации до 100 URL в Yandex, анализ страниц в Google станет доступным только после оформления подписки за определенную плату);

- serphunt.ru/indexing (дает возможность просмотреть индексацию конкретных страниц сайта, выдавая информацию об их присутствии (либо нет) в индексе ПС Google/Яндекса, позволяет одновременно анализировать до 50 гиперссылок);

Из плагинов, позволяющих просмотреть нужную информацию об индексировании страниц сайта либо картинок, популярным считается RDS Bar.

Ускорить индексирование сайта

Чтобы ускорить процесс индексации, рекомендуется воспользоваться инструментами Google Search Console, Яндекс.Вебмастера. Из дополнительных способов стимулирования страниц – гиперссылки, социальные сигналы.

Инструменты панели Яндекс.Вебмастера

Яндекс.Вебмастер предоставляет возможности ускорить индексацию сайта следующими способами:

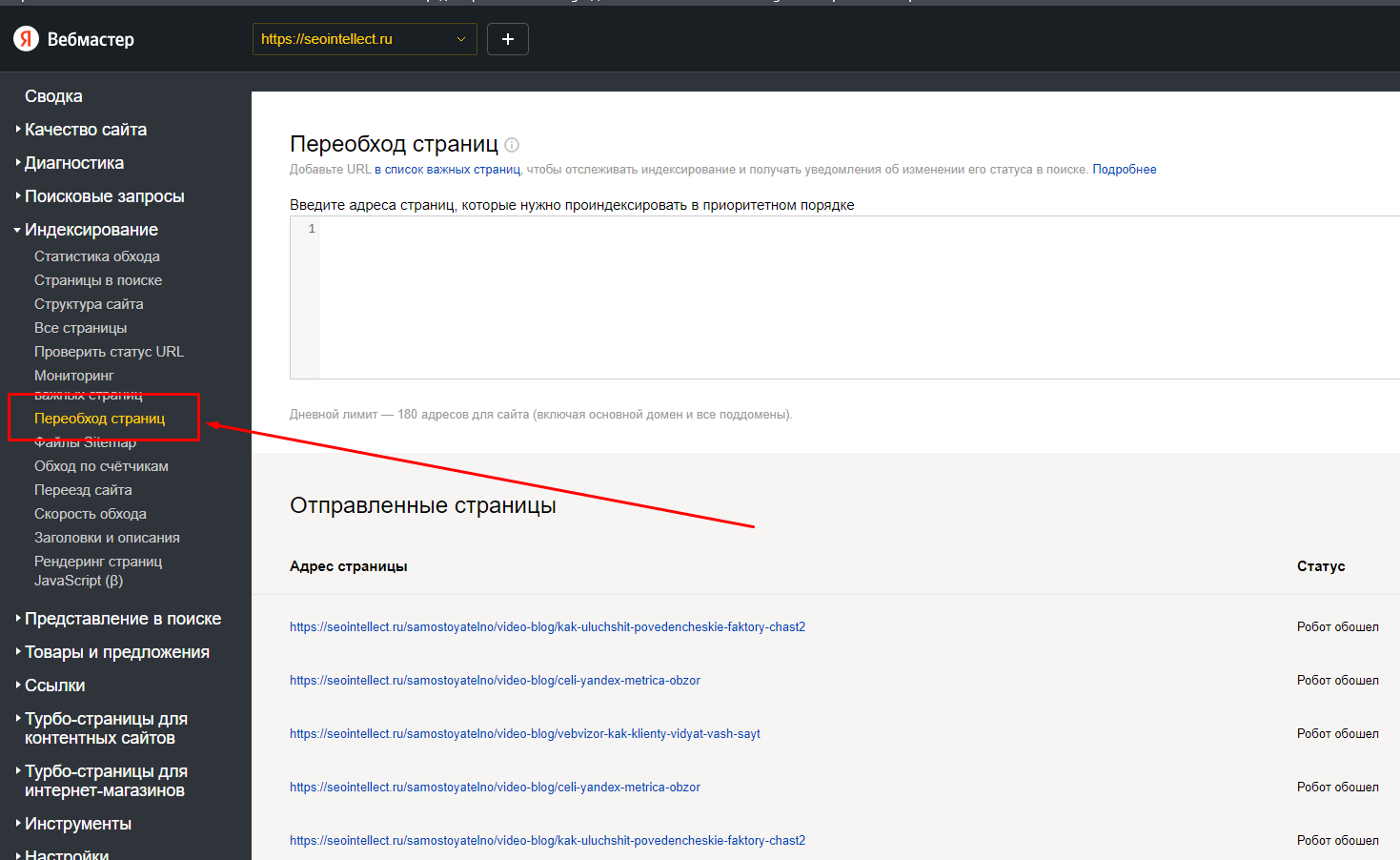

- Зайти в подраздел «Переобход страниц», расположенный во вкладке «Индексирование». Скопировать и вставить в текстовое окно необходимые адреса и кликнуть на «Отправить». Пользователю предоставляется определенный ежедневный лимит на проверку страниц (количество зависит от конкретного сайта, причем параметры не разглашаются).

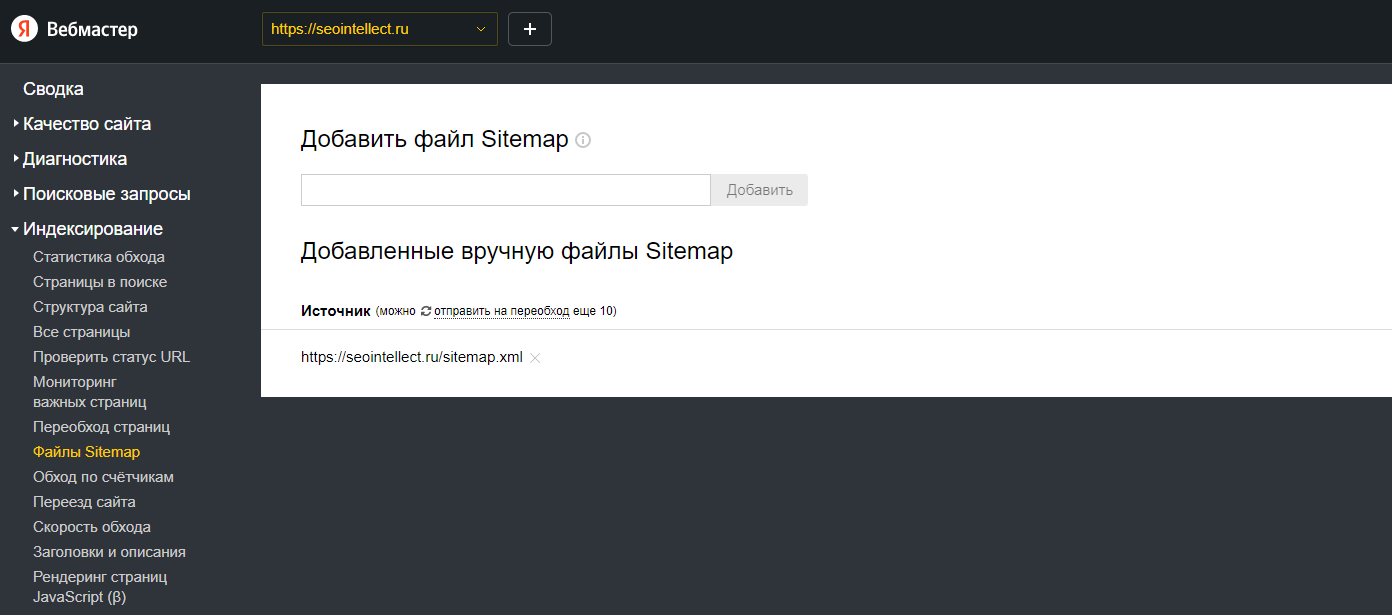

- Перейти в подраздел «Файлы Sitemap» (тоже находится во вкладке «Индексирование»). Вверху страницы, в окне ввода, необходимо добавить файл sitemap.xml с соответствующими ссылками на контент и запросить обход.

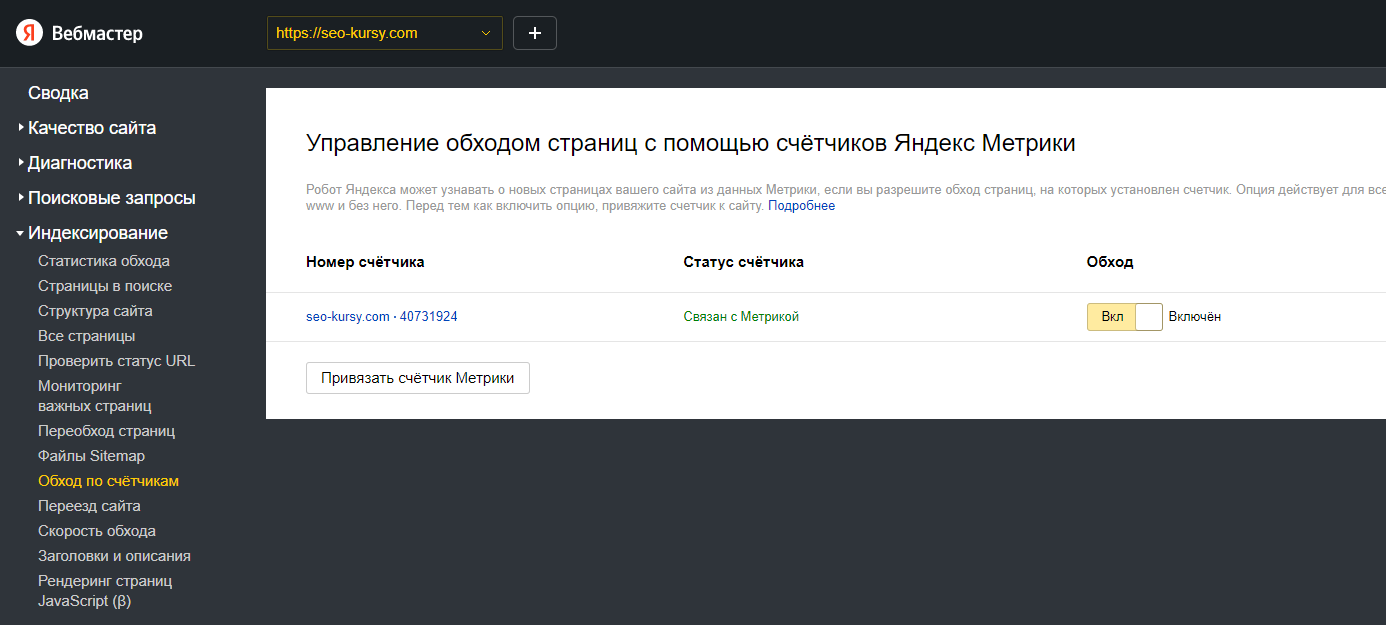

Популярным способом, чтобы ускорить процесс индексации, считается подключение обхода роботами посредством счетчиков Яндекс.Метрики. Для использования такого метода необходимо подтверждение прав на ресурс. После нужно зайти в подраздел «Обход по счетчикам», расположенный в Яндекс.Вебмастере, и поставить отметку о разрешении обхода, не забывая сохранять изменения.

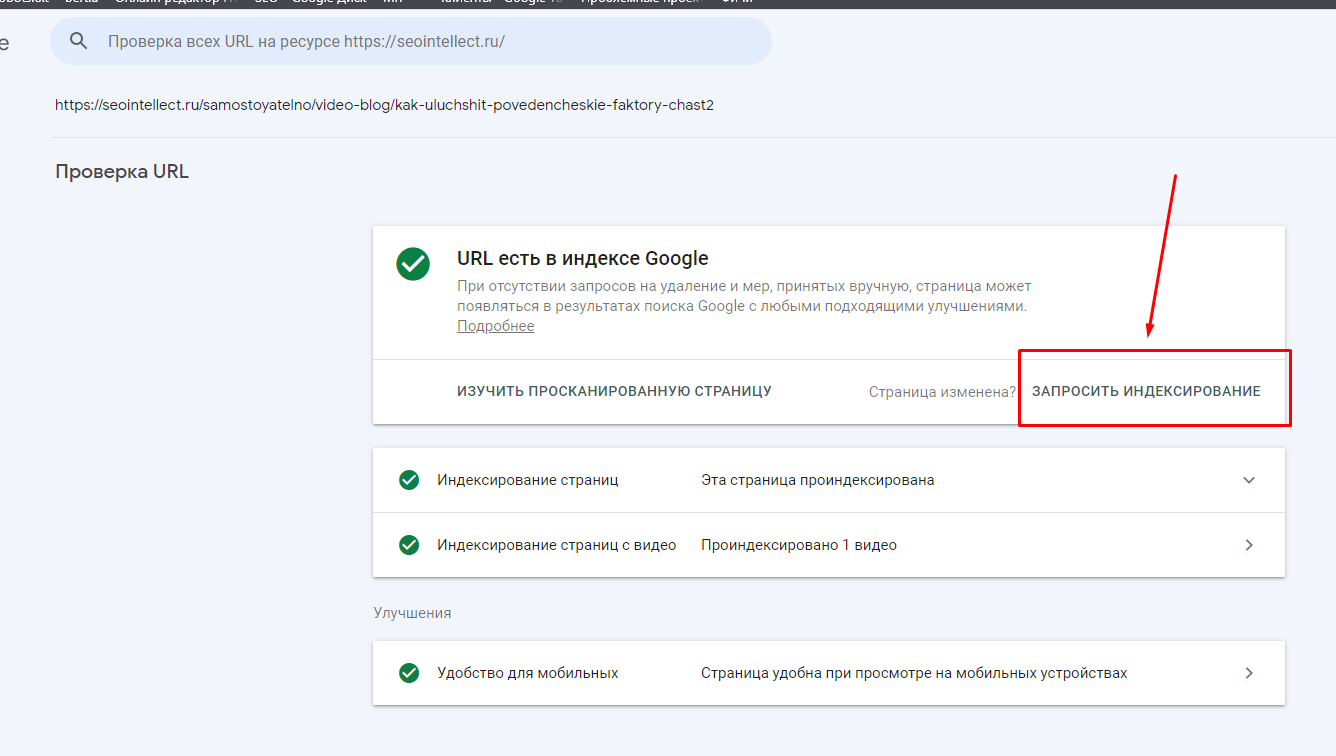

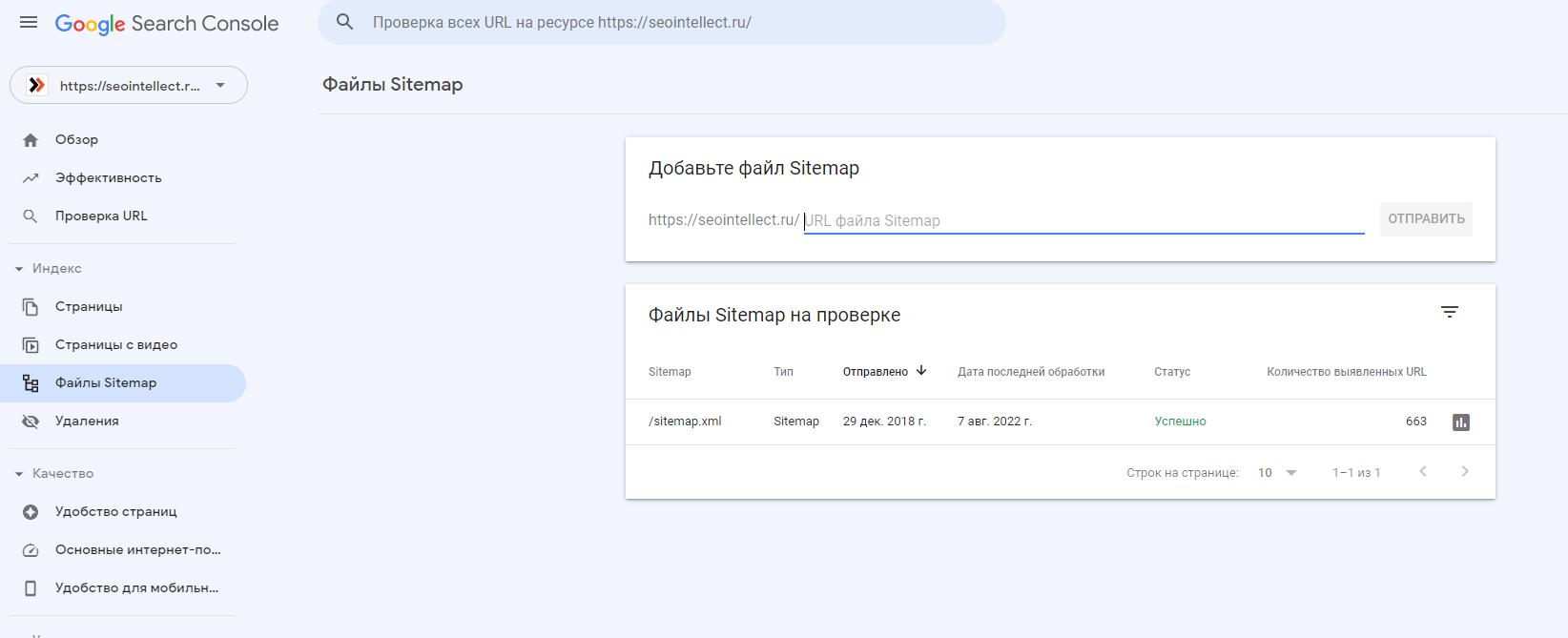

Google Search Console

Для ускорения индексирования конкретной страницы достаточно скопировать и вставить URL-адрес в окно проверки, далее кликнуть «Запросить индексацию». Это позволит воспользоваться приоритетом для выполнения сканирования контента.

При необходимости ускорить индексацию нескольких страниц сайта, рекомендуется включить их адреса в sitemap.xml, а гиперссылку на него – в подраздел «Файлы Sitemap». Останется только добавление файла в окно проверки и запрос обхода ресурса роботами.

Ускорение индексации сайта посредством ссылок

При частой публикации контента на сайте и значительной аудитории роботы постоянно посещают ресурс в поисках новой и актуальной информации. Иногда возможны ситуации, когда боты практически не покидают площадки, сканируя данные безостановочно (к таким проектам относятся крупные порталы, новостные издания и пр.). Поэтому, если разместить на подобном ресурсе ссылку на собственный сайт, роботы быстро перейдут по ней, запуская процесс индексации найденной страницы.

Чтобы воспользоваться методом, достаточно обратиться к администрации сторонней площадки и согласовать условия размещения обратной гиперссылки. К тому же многие проекты самостоятельно предлагают услугу за определенную плату.

Раньше популярным методом ускорения индексации считалось размещение ссылок на конкретные страницы в социальных сетях, причем популярной площадкой выступал Twitter. Однако впоследствии возможность ограничили и добавили вначале атрибут rel=”nofollow”, который запрещал ботам осуществлять переход, а потом и вовсе стали проставлять гиперссылки при помощи прокладку с редиректом. В результате поисковые алгоритмы перестали доверять подобным сигналам, и способ индексации через социальные сети оказался не рабочим.

Также роботы часто находятся на различных блог-платформах (например, «Живой Журнал»). Поэтому некоторые стараются разместить на таких проектах посты с указанием перехода на собственный сайт.

Однако сейчас работа со ссылками не столь актуальна, поскольку не имеет особого смысла. Поисковые роботы и Яндекса, и Google достаточно быстро могут находить сайты и сканировать контент, в результате чего индексация занимает несколько дней. Раньше алгоритмам системы не хватало мощностей, поэтому период длился неделями, а иногда – и месяцами.

К дополнительному способу практически мгновенно проиндексировать контент на сайте относится запуск рекламной кампании. Например, в Google Adsense, Яндекс.Директе. Причем вебмастеру достаточно даже создания объявления, чтобы страница, на которую указывает ссылка из него, стала приоритетной в очереди на сканирование поисковыми роботами.

Влияние доменной зоны и домена на процесс индексирования сайта

Название доменной зоны, как и самого домена, не оказывает влияния на индексацию ресурса. Сейчас существуют тысячи разных адресов, которые не только не связаны со странами, но и не ассоциируются со сферой деятельности, событиями либо предметами, что абсолютно не мешает проектам находиться в топе выдачи и хорошо ранжироваться поисковыми системами.

Даже кириллические домены, популярные в России и некоторых государствах постсоветского пространства, не испытывают проблем с индексацией сайта. У них могут возникать затруднения, связанные с ограничениями почты, а также гиперссылками, поскольку для совместимости происходит изменение адреса в т. н. punycode (например, домен ресурс.рф выглядит как http://xn--e1avbdbk.xn--p1ai), а конкретные страницы могут представлять собой длинный набор непонятных символов (та же Википедия: https://ru.wikipedia.org/wiki/%D0%97%D0%B0%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F_%D1%81%D1%82%D1%80%D0%B0%D0%BD%D0%B8%D1%86%D0%B0.

Закрытие сайта от индексации

Чтобы запретить индексирование сайта либо страниц, рекомендуется воспользоваться следующими способами:

- Прописать на странице HTTP-заголовка X-Robots-Tag. В отличие от мета-тега, ограничивается индексация любого документа на сайте, включая файлы PDF, картинки.

- Ограничить индексацию, внеся изменения в файл robots.txt. Метод работает только для поисковой системы Яндекса, в результате чего закрытые данные на сайте удаляются из выдачи. Google воспринимает robots.txt в качестве рекомендации, поэтому, если на страницу проставлены гиперссылки со сторонних площадок, информация может попасть в индекс (однако с пометкой для роботов, что содержимое закрыто в файле).

- Задать пароль для входа на ресурс посредством файлов .htpasswd и .htaccess, что не позволит поисковому боту зайти на сайт для сканирования информации. Причем необязательно полностью закрывать площадку, достаточно поставить пароль для отдельных страниц либо подразделов. Недостаток способа – данные, находящиеся уже в выдаче, придется удалять самостоятельно, поскольку ограничивается только индексация еще не добавленных в базу адресов.

- Указать тег link rel=”canonical”, что дает возможность склеивать дубли с каноничными страницами сайта. Однако, несмотря что такой метод проверенный, 100%-ой гарантии нет, поскольку поисковыми алгоритмами это воспринимается не в качестве правила, а только рекомендации, в результате чего роботы самостоятельно решают, индексировать контент либо нет.

- Настроить редирект на другие адреса. В результате, если информация прошла индексацию, в выдачу попадет страница сайта, на которую перенаправляется пользователь. Причем сервер должен отдавать код редиректа 301, а не 302. Дополнительно можно указать параметры 404, 410, что характерно для удаленных адресов, но действует и для рабочего контента, поскольку роботы исключат информацию из поиска.

- Проставить на конкретной странице строчку между мета-тегами , что позволит достаточно быстро исключить выбранный контент из выдачи после обхода сайта роботом. Такой метод хорошо работает независимо от поисковой системы, причем существуют и варианты только для Яндекса (), и Google ().

Индексация сайта выполняется периодически, причем Google обновляет базу в постоянном режиме, а Яндекс – при осуществлении апдейтов примерно раз в 3 дня. Частота сканирования ресурсов может различаться и зависеть как от объема контента, страниц, ключевых слов, так и других факторов, включая краулинговый спрос ПС для конкретной площадки, скорость загрузки и другие факторы.

Время чтения 13 минут | прочитали: 1321

Время чтения 13 минут | прочитали: 1321