В мире SEO есть большое число инструментов, чтобы управлять видимостью сайта, но ни один не вызывает столько вопросов, как скромный документ robots.txt. Этот небольшой текстовый документ, занимающий всего несколько килобайт, способен как открыть двери поисковикам к контенту, так и наглухо закрыть их. Почему же этот файл так важен? Давайте разберёмся.

В этой материале мы разберем:

- Как выглядит robots.txt и для чего он нужен.

- Как он создается и настраивается без помощи программистов.

- Типовые ошибки и готовые кейсы для разных типов сайтов.

Что такое robots.txt и зачем он нужен?

Robots.txt — это своеобразный "договор о ненападении" между вашим сайтом и поисковыми роботами. Созданный еще в 1994 году, этот стандарт выполняет три ключевые функции:

- Контроль бюджета сканирования — показывает поисковым роботам, что на сайте стоит игнорировать

- Защита конфиденциальности — закрывает доступ к админ-панелям и тестовым средам

- Оптимизация индексации — помогает поисковикам быстрее находить нужный контент

Яркий пример: В 2021 году один из крупных новостных порталов случайно закрыл доступ ко всем статьям через robots.txt, что привело к мгновенному падению трафика на 89%.

История создания и развития стандарта

Эволюция robots.txt — это история интернета в миниатюре:

- 1994: Первая версия для робота WebCrawler

- 1996: Поддержка масок (* и $) в Yahoo

- 2008: Google и Яндекс начинают учитывать директиву Sitemap

- 2022: Официальная стандартизация как RFC 9309

Почему правильная настройка критически важна для SEO?

- Скорость индексации: Сайты с грамотным robots.txt попадают в топ на 30-40% быстрее

- Безопасность: Заблокированные разделы не отображаются в кэше поисковиков

- Эффективность: Роботы не тратят время на сканирование бесполезных страниц

Robots.txt — это фундамент, на котором строится вся SEO-оптимизация сайта. Его правильная настройка требует понимания не только технических аспектов, но и стратегии продвижения. В следующих разделах мы подробно разберём, как избежать распространенных ошибок и максимально эффективно использовать этот мощный инструмент.

Основы работы с robots.txt

Прежде чем приступать к настройке robots.txt, необходимо понять базовые принципы его работы. Многие вебмастера совершают ошибки уже на этом этапе, что приводит к проблемам с индексацией. Давайте разберемся, как поисковые системы взаимодействуют с этим файлом и какие ограничения нужно учитывать.

Принцип работы и расположение файла

Robots.txt — это первый файл, который ищет поисковый робот при посещении сайта. Важные особенности:

- Расположение: Находится в корне домена (https://пример.ру/robots.txt)

- Формат: Простой текстовый файл, созданный в коде UTF-8

- Размер файла: Не должен превышать 500 Кб (рекомендуется до 50 Кб)

Совет: Проверьте доступность файла, введя его адрес в браузере. Если вы видите содержимое — всё в порядке.

Взаимодействие с поисковыми роботами

Разные поисковые системы по-разному интерпретируют правила:

| Поисковик | Скорость обновления | Особенности |

| До 24 часов | Игнорирует некоторые ошибки синтаксиса | |

| Яндекс | До 72 часов | Строго проверяет формат файла |

| Bing | До 48 часов | Требует явного указания Sitemap |

Ограничения robots.txt

Важно понимать, чего НЕ может этот файл:

- Не запрещает индексацию — страницы из Disallow могут попасть в индекс, если на них есть ссылки

- Не защищает контент — файл открыт для всех, включая конкурентов

- Не управляет рейтингом — разрешённые страницы не гарантируют высоких позиций

Отличие от meta robots и других методов:

Главное преимущество robots.txt — он действует на уровне всего сайта. Сравнение методов:

| Характеристика | robots.txt | meta robots | htaccess |

| Уровень воздействия | Сайт | Страница | Сервер |

| Простота настройки | Высокая | Средняя | Низкая |

| Гибкость | Ограниченная | Высокая | Максимальная |

Понимание этих основ позволит вам избежать самых распространённых ошибок при работе с robots.txt. Помните: этот файл — лишь один из инструментов управления индексацией, и для максимальной эффективности его нужно использовать в комплексе с другими методами. В следующих разделах мы подробно разберём синтаксис и практические примеры настройки.

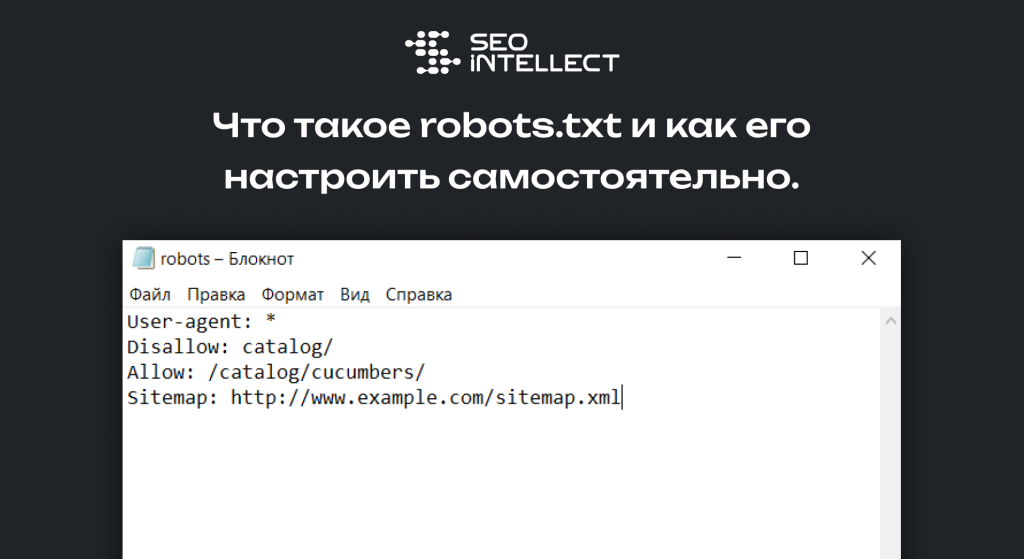

Синтаксис и основные директивы robots.txt

Robots.txt работает по строгим правилам. Малейшая ошибка в синтаксисе — и поисковые роботы могут проигнорировать ваши инструкции. Разберём ключевые директивы и их применение.

User-agent: указываем целевых роботов

Эта директива определяет, для какого поискового бота предназначены правила.

Примеры:

User-agent: * # Правила для все роботов

User-agent: Googlebot # Только для основного робота Google

User-agent: Yandex # Только для Яндекса

Важно:

- Если не указать User-agent, робот проигнорирует весь блок.

- Можно создавать отдельные правила для разных ботов.

Disallow: запрещаем сканирование

Директива блокирует доступ роботов к указанным разделам.

Примеры:

Disallow: /admin/ # Запрет сканирования админки

Disallow: /tmp/ # Блокировка временных файлов

Disallow: /? # Фильтры с параметрами (например, сортировка товаров)

Особенности:

- Пустой Disallow: разрешает сканирование всего сайта.

- Слэш (/) в начале пути обязателен.

Allow: разрешаем доступ к конкретным страницам

Используется для исключений внутри запрещённых разделов.

Пример:

User-agent: *

Disallow: /blog/ # Блокируем весь блог

Allow: /blog/seo-tips # Разрешаем индексировать одну страницу

Когда применять?

- Если нужно закрыть раздел, но оставить ключевые страницы.

- Для тонкой настройки краулингового бюджета.

Sitemap: указываем путь к карте сайта

Помогает роботам быстрее находить важные страницы.

Пример:

Sitemap: https://site.com/sitemap.xml

Sitemap: https://site.com/sitemap-imahes.xml

Правила:

- Лучше указывать полный URL (с https://).

- Можно добавить несколько карт сайта.

Правила использования символов

- * — любая последовательность символов (кроме /).

- $ — точное совпадение конца строки.

Примеры:

Disallow: /*.pdf$ # Блокировка всех PDF-файлов

Disallow: /search?* # Запрет страниц с параметрами поиска

Комментарии в robots.txt

Для пояснений используйте решётку #:

# Запрещаем сканирование служебных папок

Disallow: /temp/

Disallow: /backup/

Пошаговое создание robots.txt

Давайте рассмотрим основные этапы:

Шаг 1. Анализ структуры сайта

Перед созданием файла определите:

- Какие страницы не должны индексироваться (админки, дубли, служебные разделы).

- Где находится карта сайта (sitemap.xml).

Пример для интернет-магазина:

- Запретить: /cart/, /user/, /search/.

- Разрешить: /catalog/, /blog/.

Шаг 2. Написание правил

Базовый шаблон:

User-agent: *

Disallow: /private/

Allow: /public/

Sitemap: https://site.com/sitemap.xml

Для WordPress:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Allow: /wp-content/uploads/

Sitemap: https://site.com/sitemap_index.xml

Шаг 3. Проверка синтаксиса

Используйте инструменты:

Частые ошибки:

- Лишние пробелы после :.

- Неправильные пути (например, Disallow: admin вместо Disallow: /admin/).

Шаг 4. Загрузка на сервер

- Расположите файл в корне сайта (https://пример.ру/robots.txt).

- Проверьте доступность по URL.

Как видите, ничего сложного.

Типовые примеры настройки robots.txt

Верна конфигурация robots.txt зависит от типа сайта и его технической реализации. Ниже — готовые шаблоны для популярных платформ и структур с разбором ключевых нюансов. Каждый пример включает:

- Базовые правила для основных поисковых роботов

- Специфичные директивы для платформы

- Пояснения по критически важным запретам

Блог на WordPress

User-agent: *

Disallow: /wp=admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-json/

Disallow: /?s= # Поиск по сайту

Disallow: /comments/feed/

Allow: /wp-content/uploads/

Sitemap: https://example.com/wp-sitemap.xml

Разбор по пунктам:

- Disallow: /wp-json/ — блокирует REST API WordPress (может раскрывать служебные данные).

- Disallow: /?s= — предотвращает индексацию страниц внутреннего поиска (часто создают дубли).

- Allow: /wp-content/uploads/ — явно разрешает сканирование изображений и документов.

Для Yoast SEO:

Добавьте строку:

Disallow: /yoast-sitemap-index.xsl

Интернет-магазин на 1С-Битрикс

User-agent: *

Disallow: /bitrix/

Disallow: /auth/

Disallow: /personal/

Disallow: /upload/resize_cache/

Disallow: /*register=

Disallow: /*forgot_password=

Allow: /upload/catalog/*.jpg$ # Изображения товаров

Sitemap: https://shop.ru/sitemap_iblock_1.xml

Ключевые моменты:

- Disallow: /bitrix/ — закрывает системные скрипты CMS.

- Disallow: /register= — блокирует URL регистрации (персональные данные).

- Разрешение только оптимизированных изображений (.jpg$).

Для фильтров:

Disallow: /*?filter=*

Disallow: /*?sort=price

Медиапортал с видео и изображениями

User-agent: Googlebot-Image

Allow: /images/optimized/

Disallow: /images/temp/

User-agent: Googlebot-Video

Allow: /video/preview/

Disallow: /video/raw/

User-agent: *

Disallow: /admin/

Sitemap: https://media.com/sitemap-media.xml

Особенности:

- Отдельные правила для медиароботов.

- Запрет исходников видео (/video/raw/), но разрешение превью.

Мультиязычный сайт

User-agent: *

Disallow: /en/admin/

Disallow: /de/private/

Allow: /en/blog/

Allow: /de/news/

Sitemap: https://site.com/sitemap-en.xml

Sitemap: https://site.com/sitemap-de.xml

Что проверить:

- Соответствие путей реальной структуре.

- Нет ли конфликтов между Allow и Disallow для разных языков.

Сайт на Tilda (конструктор)

User-agent: *

Disallow: /tilda-ajax/

Disallow: /tilda-blocks/

Disallow: /forum/ # Если есть UGS

Allow: /images/

Sitemap: https://tilda-site.com/sitemap.xml

Проблемы Tilda:

- Автоматически генерируемые URL (/tilda-ajax/).

- Важно явно разрешать сканирование изображений.

При адаптации шаблонов:

- Тестируйте изменения в Search Console.

- Проверяйте, не заблокированы ли важные страницы.

- Обновляйте файл при изменении структуры сайта.

Для сложных проектов (маркетплейсы, SaaS) рассмотрите динамическую генерацию robots.txt

Распространенные ошибки и их исправление

Даже опытные разработчики допускают ошибки в robots.txt. Разберём самые критичные из них и научимся исправлять — это убережет ваш сайт от потери позиций в поиске.

Критические ошибки синтаксиса:

Пункт 1: Неправильные пути

Ошибка:

Disallow: /admin # Нет закрывающего слеша

Последствие: Робот Googlebot может проигнорировать правило.

Пункт 2: Лишние пробелы

Ошибка:

User-agent: * # Лишние пробелы после двоеточия

Последствие: Яндекс.Вебмастер отметит файл как некорректный.

Пункт 3: Неверный регистр

Ошибка:

user-agent: * # Строчная буква, должно быть User-agent

Последствие: Некоторые роботы не распознают директиву.

Проверяйте файл в валидаторах Google и Яндекса перед загрузкой на сервер. Это займет 2 минуты, но спасет от долгой отладки.

Инструменты для работы с robots.txt

Для создания и проверки robots.txt не обязательно быть техническим специалистом. Эти инструменты помогут всё сделать правильно даже новичкам.

Официальные тестеры

Пункт 1: Google Search Console

- Проверяет синтаксис.

- Показывает, какие URL заблокированы.

- Ссылка: Инструмент «Проверка robots.txt» в GSC.

Пункт 2: Яндекс.Вебмастер

- Анализирует текущий файл.

- Находит конфликты директив.

- Раздел: «Инструменты» → «Анализ robots.txt».

Применяйте эти инструменты при любых изменениях в robots.txt. Они помогают увидеть ошибки «глазами поисковых роботов».

Продвинутые техники и рекомендации

Когда базовые настройки robots.txt освоены, можно переходить к оптимизации краулингового бюджета и комбинированию методов управления индексацией. Эти приемы особенно полезны для крупных сайтов с тысячами страниц.

Управление краулинговым бюджетом

Проблема: Поисковые роботы тратят время на сканирование маловажных страниц (фильтры, сессии, дубли).

Решение:

- Закрывайте от индексации:

Disallow: /*?sort=

Disallow: /*?session_id=

Disallow: /print/

- Приоритезируйте контент:

- Разрешайте сканирование только ключевых разделов (Allow: /blog/).

- Используйте Sitemap для указания важных URL.

Пример для новостного сайта:

User-agent: Googlebot-News

Allow: /news/

Disallow: /news/?page=

-

Комбинация с другими методами

Robots.txt — не единственный инструмент. Дополните его:

- Мета-тегами: для точечного запрета.

- HTTP-заголовками: X-Robots-Tag: noindex для PDF-файлов.

- Каноническими ссылками: Для борьбы с дублями.

Важно: Если страница запрещена в robots.txt, робот не увидит ее мета-теги. Сначала Allow, потом noindex.

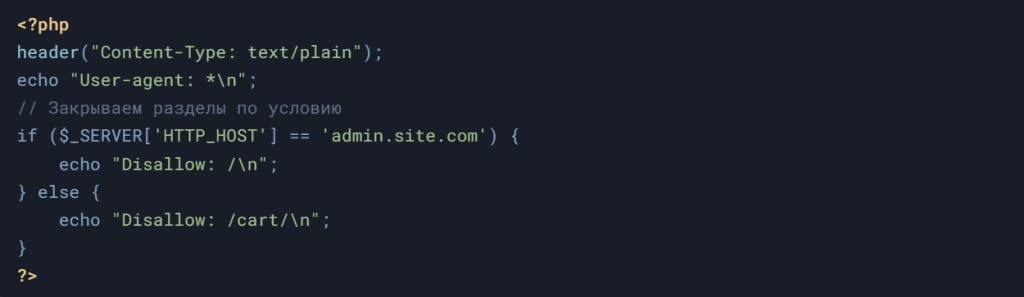

Динамический robots.txt

Для сайтов с изменяемой структурой (например, маркетплейсов) файл можно генерировать автоматически:

Пример на PHP:

-

Плюсы:

- Разные правила для поддоменов.

- Автоматическое обновление при изменении структуры.

Регулярный аудит

Раз в 3 месяца проверяйте:

- Актуальность запретов: Не блокируются ли нужные страницы?

- Логи сервера: Какие URL сканируют роботы?

- Ошибки в Search Console: Раздел «Сканирование» → «Файлы robots.txt».

Эти техники помогут точечно управлять индексацией без риска случайных запретов. Главное — тестировать изменения перед внедрением.

Заключение и чек-лист

Файл robots.txt — это фундамент технической SEO-оптимизации. Его некорректная настройка приводит к катастрофическим последствиям: от потери трафика до блокировки доступа поисковых роботов к критически важным страницам. В этом разделе — итоговые рекомендации, расширенный чек-лист из 15 пунктов и кейсы из реальной практики.

Итоговые рекомендации

- Принцип минимальных ограничений

Ошибка:

User-agent: *

Disallow: / # Полный запрет индексации

-

Правило: Запрещайте только то, что действительно не должно попасть в поиск:

- Служебные папки (/admin/, /tmp/).

- Страницы с персональными данными (/user/profile/).

- Параметры сортировки/фильтрации (/?color=red).

- Приоритеты для поисковых систем

Для Яндекса и Google можно задать разные правила:

User-agent: Googlebot

Disallow: /not-for-google/

User-agent: Yandex

Disallow: /not-for-yandex/

- Контроль дублирующего контента

Если на сайте есть зеркала страниц (например, с www и без), добавьте:

User-agent: *

Disallow: /*?utm_*

Disallow: /*ref=*

Расширенный чек-лист (15 пунктов)

Перед публикацией файла проверьте:

- Технические требования:

- Файл расположен в корне: https://site.com/robots.txt.

- Название в нижнем регистре (robots.txt, не Robots.TXT).

- Кодировка UTF-8 без BOM.

- Синтаксис:

- Каждая директива с новой строчки.

- Пустые строки только между блоками.

- Правильные подстановочные знаки ( и $).

- Безопасность:

- Нет запрета на весь сайт (Disallow: /).

- Не заблокированы CSS/JS (это вредит рендерингу).

- SEO-оптимизация:

- Указана актуальная карта сайта (Sitemap:).

- Разрешены к индексации:

- Основные категории (/blog/, /catalog/).

- Медиафайлы (/images/optimized/).

- Для CMS:

- WordPress: закрыты /wp-admin/, /wp-includes/.

- OpenCart: запрещены /route=checkout/, /route=account/.

Реальные кейсы проблем и решений

Кейс 1: Сайт не индексируется в Google

Проблема: После обновления robots.txt трафик упал на 90%.

Причина:

User-agent: *

Disallow: /

Allow: /blog/ # Директива проигнорирована

Решение:

- Убрать Disallow: /.

- Использовать noindex для страниц, которые не должны быть в поиске.

Кейс 2: Дубли страниц в Яндексе

Проблема: В поиске отображаются URL с параметрами ?session_id=123.

Исправление:

User-agent: Yandex

Disallow: /*?session_id

Disallow: /*?from=

Когда и как обновлять robots.txt

- После редизайна: Проверьте, не изменились ли пути к разделам.

- При смене CMS: Например, переход с Joomla на WordPress требует правки правил.

- По данным Search Console: Если роботы сканируют ненужные страницы.

Важно! После изменений:

- Проверьте файл в Google Tester.

- Отправьте страницы на переобход в «Инструмент инспекции URL».

- Теперь у вас есть полное руководство — от базовых принципов до продвинутых техник.

Для закрепления:

- Начните с простого шаблона.

- Постепенно усложняйте правила по мере роста сайта.

- Регулярно аудируйте файл (хотя бы раз в квартал).